pg电子娱乐平台 50亿图文中提取中文跨模态基准,奇虎360预训练框架超越多项SOTA

对于中文社区来说,本文提出的大规模跨模态基准数据集无疑是有价值的

视觉语言预训练(VLP)主要学习视觉与自然语言之间的语义对应关系。得益于海量数据、Transformer等优秀架构、CLIP等跨模态模型以及硬件设备的支持,一系列开创性的工作对VLP模型进行了探索,并在各种视觉语言任务上取得了重大进展。

通过大规模训练语料库(主要是英语),众多 VLP 模型已被证明对下游任务有益。然而,中文视觉语言数据集非常少,并且存在各种局限性。对于大规模预训练模型和下游任务微调的经典模型,中国跨模态领域缺乏包含大量高质量数据并完整定义预训练数据集的数据基准,多个下游任务训练集,以及下游任务测试集。

如何构建完整、公正、高质量的文本描述中文跨模态基准已成为迫切需要解决的问题。

近日,奇虎360人工智能研究院和清华大学的研究人员在最新论文中重点关注了大规模视觉语言数据集和跨模态表示学习模型。研究人员提出了大规模中文跨模态基准数据集 Zero,其中包含两个称为 Zero-Corpus 的预训练数据集和五个下游任务数据集,在一定程度上填补了中文图文跨模态的空白。模态数据集。州域数据集中的差距。此外,研究人员还提出了一种用于大规模跨模态学习的视觉语言预训练框架R2D2。它基于所提出的零语料库数据集进行了预训练,并在多个下游任务上进行了测试。 R2D2取得了多项超越SOTA的成果。以上数据集和模型均开源。

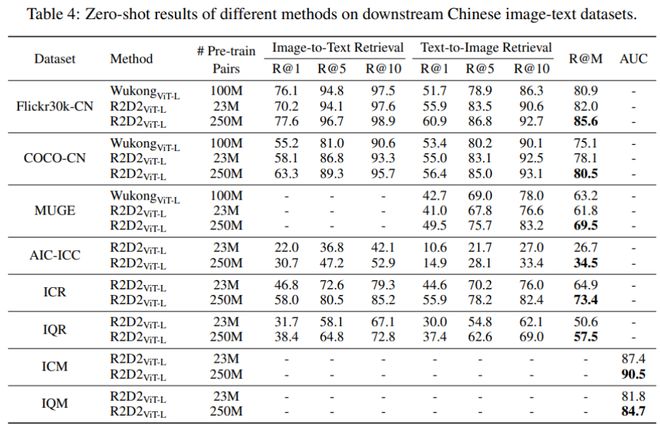

研究人员还尝试使用 2.5 亿个更大的内部数据集来训练 R2D2 模型。与2300万数据相比,模型效果还是有明显提升。尤其是在零样本任务上,与之前的SOTA相比,在Flickr30k-CN数据集上,R@M提升到了85.6%(提升了4.7%),在COCO-CN数据集上,R@M提升了至 80.5%。 (增长了5.4%),而在MUGE数据集上,R@M增长到了69.5%(增长了6.3%)。

论文地址:

零语料库预训练数据集由包含 2300 万个图像文本对的完整版本和包含 230 万个图像文本对的较小子集版本组成。其中,完整的预训练数据集是从搜索引擎收集的,包含图像和相应的文本描述,并根据用户点击率(CTR)从50亿张图像和文本中过滤出来。在完整版本上训练VLP模型可能需要大量的GPU资源,因此为了方便学术研究,研究人员还提供了230万个版本的子集,其中包含完整版本的10%的图文对。

除了两个预训练数据集之外,研究人员还提供了五个高质量的下游数据集,用于长短文本的图文检索和图文匹配任务。特别值得一提的是Flickr30k-CNA,这是一个手动翻译的数据集,比Flickr30k-CN更准确。可以用来比较中英文跨模态模型的效果,也可以用来研究翻译语料质量对结果的影响。

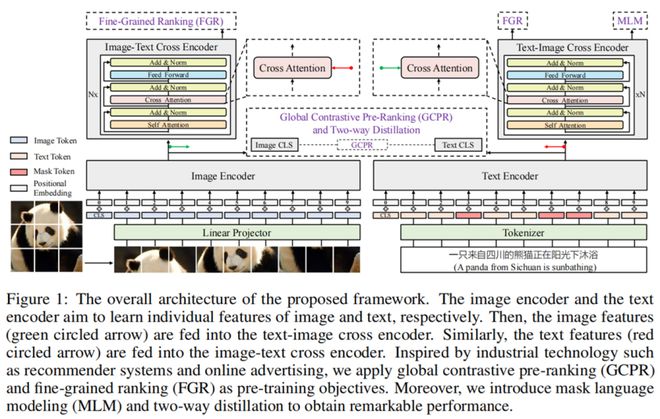

对于VLP模型,研究人员提出了一种新的跨模态学习预训练框架R2D2。该框架结合了双塔模型和单塔模型。它基于图像模态表示和文本模态表示,采用交叉注意力机制来融合图像和文本信息,受到推荐系统和在线广告等技术的启发。使用全局对比预排序(GCPR)来获得跨模态表示,最后使用细粒度排序(FGR)来进一步提高模型性能。

此外,研究人员还介绍了一种双向蒸馏方法,包括目标引导蒸馏(TgD)和特征引导蒸馏(Feature-guided Distillation,FgD)。其中,面向目标的蒸馏提高了从噪声标签中学习的鲁棒性,面向特征的蒸馏旨在提高R2D2的泛化能力。

数据集概述

预训练数据集零语料库

现有的数据收集方法有两个主要限制。首先,仅通过爬行采集到的图像与文本的对应关系较弱,噪声较多;其次,图像往往只包含一个对应的文本,文本数据缺乏多样性。

为了克服上述限制,研究人员创建了一个新的中文图像和文本预训练数据集——零语料库。他们根据用户点击对图像搜索引擎中的 50 亿张图像进行排序。排名靠前的图像表示用户在查询时点击次数最多,表明该图像与搜索查询文本最相关。此外,研究人员还删除了不恰当和有害的文字描述,并过滤掉了有害的图像。上述过程最大化了图像和文本数据之间的对应关系,并过滤出高质量的图像。研究人员按照上述方法总共处理了约 2.5 亿个最相关、高质量的图文对,最终随机选择其中 2300 万个构建公共预训练数据集。

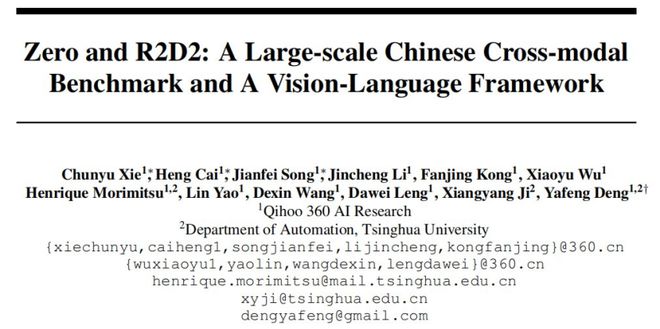

研究人员还为每张图像提供了多样化的文本描述,包括标题(Title)、内容(Content)和图像查询术语(ImageQuery)。这些信息(包括多个文本)可用于构建不同的跨模态任务,以促进对图像和文本之间的跨模态关系进行更全面的建模和研究。下图显示了一些具体示例。

零语料库图像文本对示例。

下游数据集

为了评估预训练模型的性能,大多数工作都会在各种下游数据集上进行实验。与现有的英文描述的下游数据集相比,带有中文文本的下游数据集很少。

为此,研究人员构建了四个中文图文数据集,分别是ICM、IQM、ICR和IQR。在预训练数据处理的基础上(按点击排序并过滤优质内容后),我们进一步手动标记这些下游任务的标签pg电子娱乐平台,以保证数据的准确性。对于每个下游任务数据集,将训练集、验证集、测试集按照8:1:1的比例划分为训练集、验证集、测试集。与预训练数据不同,这些下游任务的数据集只为每张图像保留一个对应的文本。

图像标题匹配数据集(ICM)用于长文本图像文本匹配和分类任务。每个图像都有相应的标题文本,详细描述该图像。研究人员首先使用 CTR 选择最相关的对,然后通过手动注释对其进行校准。总共获得了40万个图文对,其中正样本20万个,负样本20万个。

图像查询匹配数据集(IQM)用于短文本图像文本匹配和分类任务。数据收集的方法与ICM类似,只不过使用搜索查询而不是详细描述文本。 IQM还包含20万个正样本和20万个负样本

图像字幕检索数据集(ICR)用于长文本图像-文本互检任务。研究人员使用与 ICM 相同的规则收集了 200,000 个图像文本对。

图像查询检索数据集(IQR)用于短文本图像-文本互检任务。研究人员使用与 IQM 相同的规则收集了 200,000 个图像文本对。

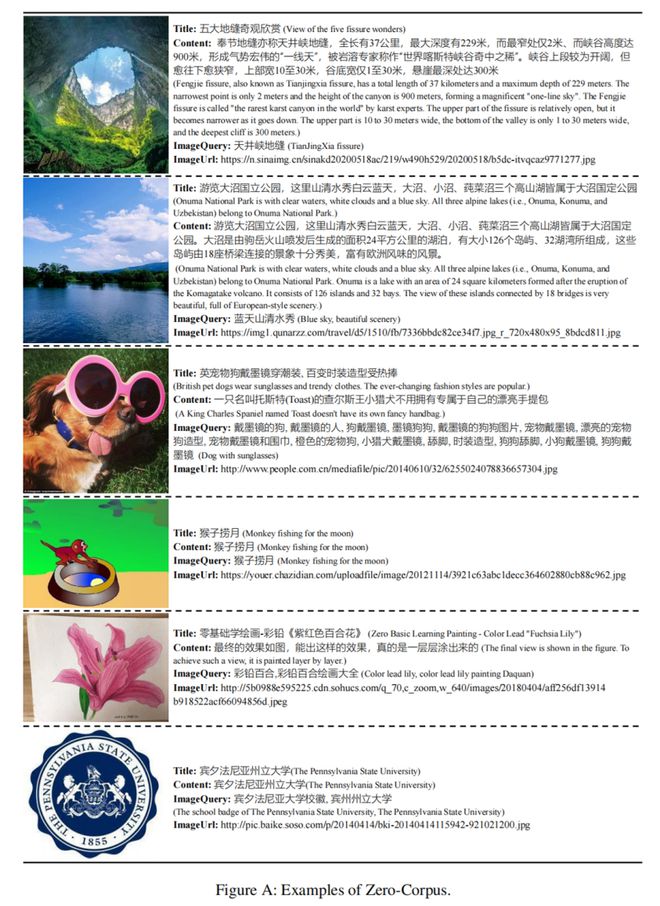

从左到右是来自 ICM、IQM、ICR 和 IQR 数据集的图形和文本示例。

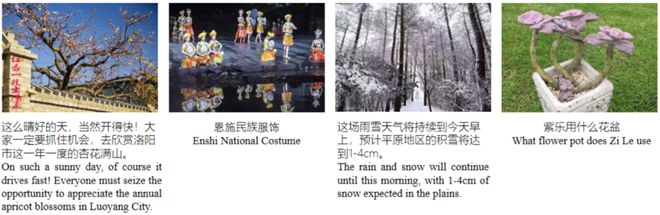

之前的Flickr30k-CN使用机器翻译来翻译Flickr30k的训练集和验证集,但是机器翻译的结果有两类常见的问题。一方面,部分句子存在一定的翻译错误;另一方面,有些句子的中文语义不顺畅。

因此,研究人员邀请了六名中英文语言学专业人士对所有 Flickr30k 数据进行了重新翻译,并对每个句子进行了仔细检查,最终生成了新的数据集 Flickr30k-Chinese All(Flickr30k-CNA),用于进行图文交叉评价。模态任务。

本文提出的 Flickr30k、Flickr30k-CN 和 Flickr30k-CNA 的示例比较。

方法概述

模型架构

下图1是R2D2预训练框架的架构概述,其中包含一个文本编码器、一个图像编码器和两个交叉编码器。其中,文本编码器和图像编码器分别将文本和图像转换为隐藏状态序列。然后,文本和图像隐藏状态通过交叉注意力在两个交叉编码器中进行交互。

研究人员使用 RoBERTa 作为文本编码器。给定一个文本序列,首先使用 RoBERTa-wwm-ext 的分词器对它们进行分词。在这里,一个特殊的 [CLS] 标记被附加到标记化文本的头部,而 [SEP] 标记被附加到尾部。然后将标记化的文本输入文本编码器。

研究人员使用 ViT 作为图像编码器。他们首先将输入图像缩放到标准尺寸,并将图像划分为多个块。然后对每个补丁进行线性映射并添加位置嵌入。此外pg麻将胡了试玩平台,可学习的 [CLS] 标记与补丁向量连接起来。最后将序列向量输入到标准Transformer模型中,得到图像隐藏状态向量。

研究人员融合了图像和文本潜在向量,并将它们输入交叉编码器。具体来说,他们使用线性映射层来改变每个文本特征和图像特征的尺寸,使它们保持一致。多层Transformer使用交叉注意力来融合两种模态的特征信息并生成最终的跨模态输出。

预训练方法

为了探索图像和文本对之间的匹配关系,研究人员设计了预排序+排序机制,即全局比较预排序(GCPR)和细粒度排序(FGR)。他们还采用掩码语言建模(MLM)来有效学习跨模态模型的表示。

首先是全局比较预排序。传统的对比学习旨在对齐多模态数据的表示(例如图像和文本对),从而最大化正对的相似度分数并最小化负对的分数。研究人员使用全局对比学习来完成预排序任务,他们在 k 个 GPU 上执行完整的反向传播。对于每个图像 I_i 和对应的文本 T_i,图像和文本的 softmax 归一化相似度分数可以定义如下:

全局对比预排序损失由交叉熵损失L_c(·)计算,如下式(2)所示:

然后是细粒度排序。如上所述,我们使用全局对比预排序来获得图像和文本的单一表示。基于这些表示,进一步利用细粒度排名损失来执行细粒度排名任务。这是一个二元分类任务,旨在预测图像和文本是否匹配。

研究人员将h_I_[CLS]和h_T_[CLS]作为两个交错编码器的输出表示。给定图像表示 h_I_[CLS] 和文本表示 h_T_[CLS],研究人员将它们输入全连接层 g(·) 以获得它们各自的预测概率。令 y 代表二元分类的真实标签,研究人员计算细粒度排名损失如下。

研究人员将屏蔽语言建模损失应用于文本-图像交叉编码器,以提高在标记级别对文本和图像之间的关系进行建模的能力。 15% 的文本标记在输入中被屏蔽,并且所有这些标记都被替换为 [MASK] 标记。

在研究人员的模型中,屏蔽语言建模任务使用屏蔽文本和相应的图像一起去噪,从而增强文本和图像之间的交互。由于细粒度排序严重依赖这种交互能力,因此研究人员提出了增强训练(ET),将屏蔽语言建模任务集成到前向图像文本对的细粒度排序的前向操作中。

双向蒸馏

大多数图像和文本预训练数据都是由半自动化程序收集的,导致数据充满噪声。不准确的标签可能会误导模型训练。为此,研究人员提出了目标导向蒸馏(TgD),一种基于师生的软目标蒸馏。为了进一步提高预训练模型的泛化性能,研究人员引入了特征引导蒸馏(FgD)。为了方便起见,他们将这两种蒸馏的组合称为双向蒸馏(TwD)。

目标导向蒸馏:为了降低从噪声标签中学习的风险,研究人员建议使用动量更新编码器生成的软目标。这里,动量更新编码器充当通过指数移动平均权重获得的蒸馏教师模型。

研究人员通过系数α将相似度得分s(·,·)与one-hot标签y(·,·)结合起来生成最终的软标签。将要

表示为最终的软标签。经过

例如,它可以定义为:

考虑到队列中特征的有效性随着时间步长的增加而降低,研究人员还维护了一个加权队列w来标记相应位置特征的可靠性。具体来说,该研究每次迭代都会将队列中的每个元素衰减 0.99,新传入的项目除外。因此,研究人员将

替换为等式 2 中的加权交叉熵损失

。使用目标导向蒸馏,

定义为:

面向特征的蒸馏:与TgD类似,研究人员使用师生范式进行面向特征的蒸馏。以文本编码器为例,学生模型是文本编码器,教师模型是通过动量更新的编码器。

为了进一步提高模型性能,研究人员对输入采用了掩蔽策略。在具体实现中,将完整的输入提供给教师模型,并将屏蔽的输入提供给学生。依托动力机制,目标是让学生的特点更加接近老师的特点。形式上pg电子麻将胡了,教师模型和学生模型的预测分布分别定义如下:

研究人员利用交叉熵损失进行面向特征的蒸馏,损失L_FgD定义为:

最后用总体预训练目标进行模型训练:

实验结果

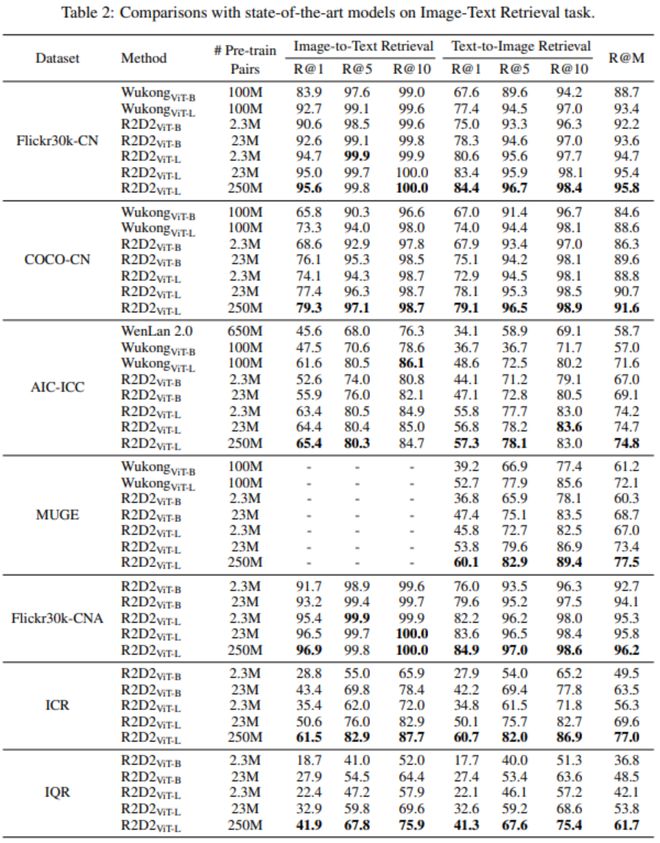

从下面的表2可以看出,研究人员提出的模型在大多数任务中都超越了之前的SOTA,即使只使用2.3M样本(约占悟空数据量的2.3%)进行训练。在 23M 个样本上进行预训练时,结果更好。在模型层面,R2D2ViT-L在所有数据集上也优于R2D2ViT-B,表明随着预训练模型变大,算法效果会变得更好。

研究人员还在提议的下游数据集上进行了实验,这些实验的结果成为了提议数据集的基线。特别是,在Flickr30k-CNA上进行实验时,研究人员使用Flickr30k-CNA的训练集对预训练模型进行微调,并在Flickr30k-CN的测试集上进行测试,以进行公平比较。从表2可以看出,在Flickr30k-CNA上微调的R2D2优于在Flickr30k-CN上微调的R2D2,因为人工翻译的Flickr30k-CNA的质量远高于机器翻译的Flickr30k-CN。

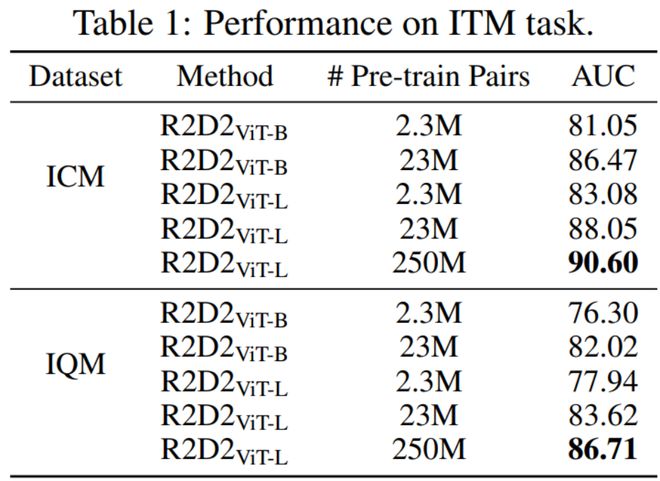

与图文检索不同,中文图文匹配(ITM)任务的数据集很少。研究人员针对中文ITM任务提出了图像标题匹配数据集(ICM)和图像查询匹配数据集(IQM),并给出了相应的结果。

研究人员使用AUC作为评价指标。从下表1可以看出,R2D2ViT-L取得了比R2D2ViT-B更好的结果。此外,R2D2ViT-L(23M)在ICM和IQM上的性能分别比R2D2ViT-L(2.3M)高出约4.97%和5.68%。这意味着更多高质量的中文数据可以提高R2D2的泛化能力。

为了进一步提高性能,研究人员使用了从 50 亿个样本中提取的 2.5 亿个图文对进行预训练。从表2可以看出,以最综合评价指标R@M衡量,该模型在Flickr30k-CN、COCO-CN、AIC-ICC、MUGE、Flickr30k-CNA、ICR、IQR等所有结果中均表现良好数据集。均超过了用23M数据训练的模型,这意味着增加数据量可以增强预训练模型的能力。同时,这些成绩也大幅超越了已公开披露成绩的文澜2.0和悟空的成绩,成为最新的SOTA。下面表1的数据表明,在图文匹配任务ICM和IQM中,用更大数据量训练的预训练模型会取得更好的结果。

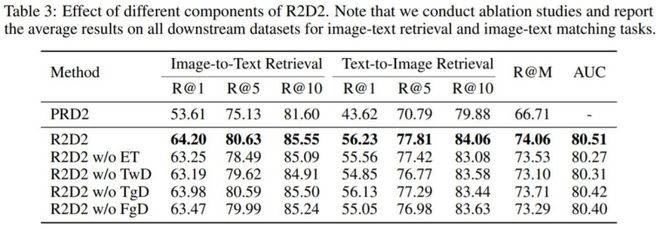

为了演示每种机制的作用,研究人员对零语料库的子集(230 万图像和文本预训练数据)进行了消融实验。为了方便起见,研究人员在消融实验中将R2D2ViT-L定义为R2D2。

细粒度排序(FGR)的效果。首先,研究人员使用全局对比预排序(GCPR)和双向蒸馏(TwD)来训练模型,将其定义为 PRD2。 PRD2 的设置与 CLIP 类似。从下面表3的第一行和第二行可以看出,R2D2在图像和文本检索任务上的表现明显优于PRD2。可以推断,结果明显优于CLIP,这说明了所提出的全局对比预排序+细粒度排序框架的有效性。

强化训练(ET)的效果。研究人员比较了取消增强式训练后的结果。从下面表3的第三行可以看出,R2D2(带有ET)在图像和文本检索任务上将recall@1提高了0.95%,AUC从80.27%提高到80.51%。 R2D2 的另一个优点是它比没有 ET 的 R2D2 使用更少的计算资源。 R2D2 需要 154.0 GFLOPs 的计算量,可以每秒 1.4 次迭代的速度运行,而没有增强训练的 R2D2 需要 168.8 GFLOPs 的计算量,只能以每秒 1.1 次迭代的速度运行。上述结果证明了增强式训练的有效性。

双向蒸馏的效果。研究人员提出的双向蒸馏包括面向目标的蒸馏和面向特征的蒸馏。当去除双向蒸馏(TwD)时,R@M从74.06%下降到73.10%,AUC从80.51%下降到80.31%。当去除特征引导蒸馏(FgD)时,R@M从74.06%下降到73.29%,性能明显下降,这表明训练期间的特征对齐很重要。同时,去除目标导向蒸馏(TgD)也会导致模型性能下降。上述结果表明,双向蒸馏是提高预训练模型泛化能力的有效方法。

零样本任务。为了证明模型的泛化性能,研究人员还进行了零样本迁移实验。从下面表4可以看出,与目前的SOTA性能WukongViT-L相比,R2D2ViT-L(23M)仅使用了不到1/4的数据,但在Flickr30k-CN和COCO-CN上取得了更好的效果。更好的性能。当引入2.5亿级预训练数据后,R2D2的准确率进一步提升。与 WukongViT-L 相比,在 Flickr30k-CN 数据集上,R@M 提升至 85.6%(提升了 4.7%),在 COCO-CN 数据 MUGE 数据集上,R@M 提升至 80.5%(增长了5.4%)。在MUGE数据集上,R@M提升至69.5%(提升了6.3%)。

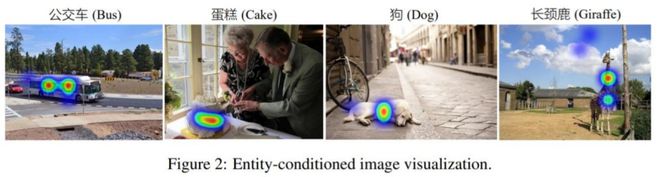

基于实体的图像注意力可视化。在这个实验中,研究人员试图将图像在COCO-CN上的注意力可视化。具体来说,他们首先从中文文本中提取一个实体,并计算图像实体对的注意力分数。下面的图 2 显示了图像上四个不同实体的视觉解释。这表明 R2D2 已经很好地学会了将文本与图像中的正确内容对齐。

鲁ICP备18019460号-4

鲁ICP备18019460号-4

我要评论